- เข้าร่วม

- 1 มิถุนายน 2011

- ข้อความ

- 15,229

- คะแนนปฏิกิริยา

- 0

- คะแนน

- 36

กูเกิลเปิดตัว EmbeddingGemma โมเดลขนาดเล็ก รันบนมือถือได้ ออฟไลน์ได้ ต้องการแรม 200MB

Body

กูเกิลยังเดินหน้าออกโมเดลขนาดเล็กในตระกูล Gemma ต่อไป หลังจาก Gemma 3 270M ที่เป็นโมเดลตั้งต้นให้นำไปปรับแต่งต่อ ก็ตามมาด้วย EmbeddingGemma โมเดลที่ออกแบบมาสำหรับ on-device AI แบบพร้อมใช้งานทันที

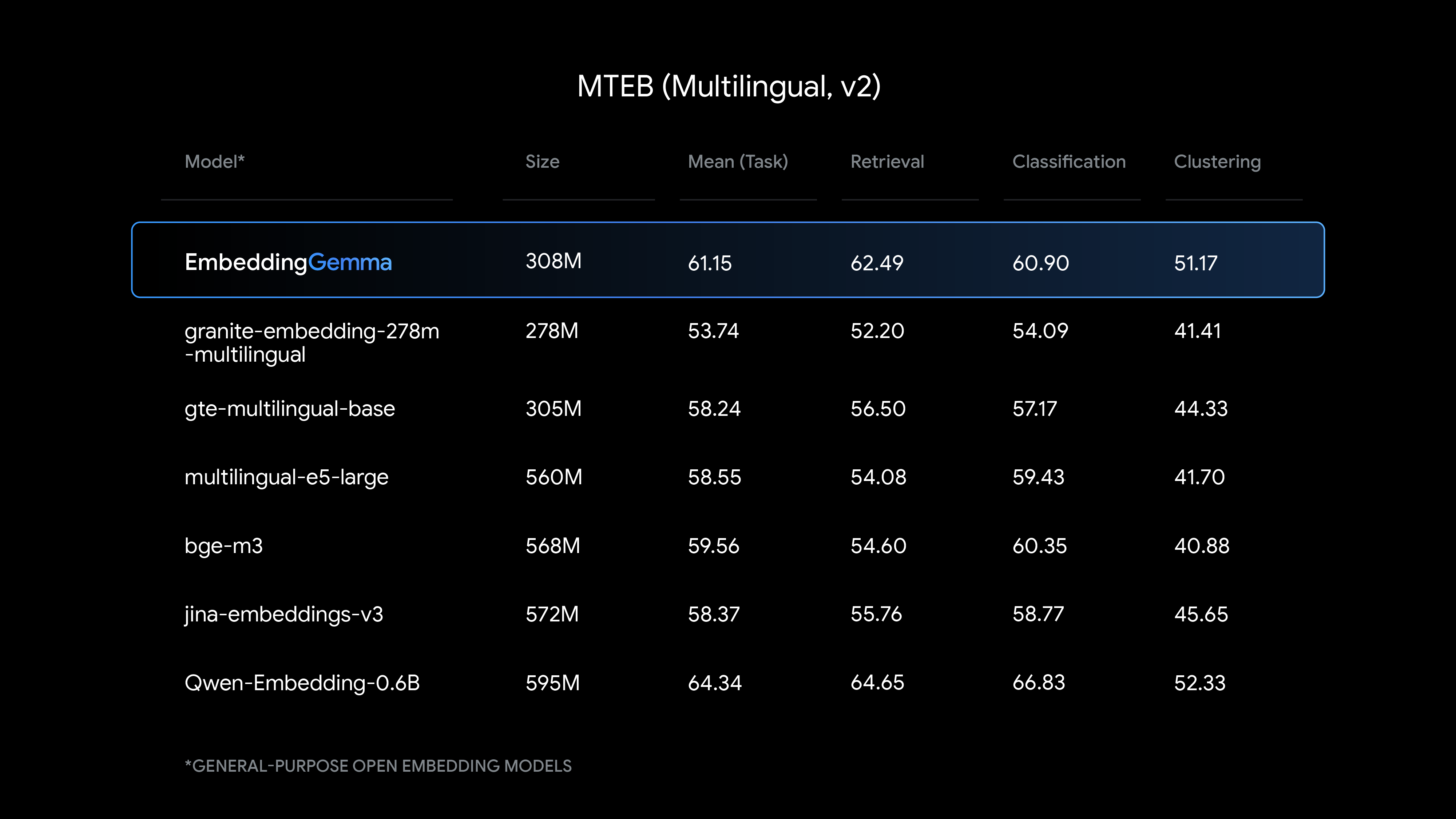

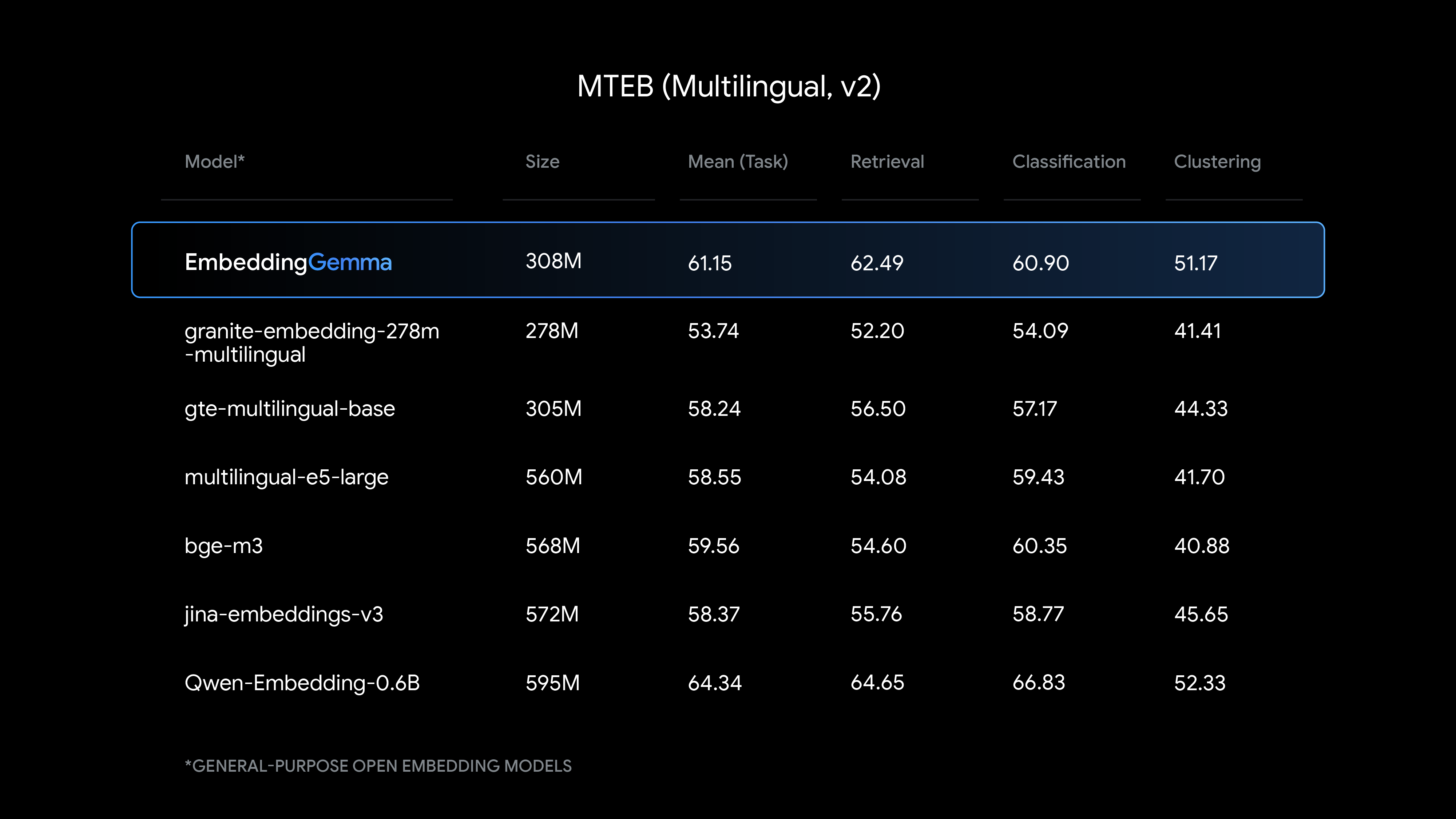

EmbeddingGemma ปรับแต่งมาจาก Gemma 3 อีกที มีขนาดพารามิเตอร์ 308M มีขนาดเล็กพอที่จะทำงานภายใต้แรม 200MB (quantization แล้ว) รันงานในอุปกรณ์แบบออฟไลน์ แต่ถึงแม้ขนาดเล็ก โมเดลมีประสิทธิภาพสูง ตอบเร็ว ทำคะแนนเบนช์มาร์คได้สูงกว่าโมเดลขนาดใกล้เคียงกันตัวอื่นๆ อย่างชัดเจน

ในแง่ของความเข้ากันได้ EmbeddingGemma รองรับการรันบนเฟรมเวิร์ค AI ชื่อดังเกือบทั้งวงการ เช่น sentence-transformers, llama.cpp, MLX, Ollama, LiteRT, transformers.js, LMStudio, Weaviate, Cloudflare, LlamaIndex, LangChain

โมเดลเปิดให้ใช้งานบน HuggingFace, Kaggle, Vertex AI

ที่มา - Google

mk Sat, 06/09/2025 - 20:03

Continue reading...

Body

กูเกิลยังเดินหน้าออกโมเดลขนาดเล็กในตระกูล Gemma ต่อไป หลังจาก Gemma 3 270M ที่เป็นโมเดลตั้งต้นให้นำไปปรับแต่งต่อ ก็ตามมาด้วย EmbeddingGemma โมเดลที่ออกแบบมาสำหรับ on-device AI แบบพร้อมใช้งานทันที

EmbeddingGemma ปรับแต่งมาจาก Gemma 3 อีกที มีขนาดพารามิเตอร์ 308M มีขนาดเล็กพอที่จะทำงานภายใต้แรม 200MB (quantization แล้ว) รันงานในอุปกรณ์แบบออฟไลน์ แต่ถึงแม้ขนาดเล็ก โมเดลมีประสิทธิภาพสูง ตอบเร็ว ทำคะแนนเบนช์มาร์คได้สูงกว่าโมเดลขนาดใกล้เคียงกันตัวอื่นๆ อย่างชัดเจน

ในแง่ของความเข้ากันได้ EmbeddingGemma รองรับการรันบนเฟรมเวิร์ค AI ชื่อดังเกือบทั้งวงการ เช่น sentence-transformers, llama.cpp, MLX, Ollama, LiteRT, transformers.js, LMStudio, Weaviate, Cloudflare, LlamaIndex, LangChain

โมเดลเปิดให้ใช้งานบน HuggingFace, Kaggle, Vertex AI

ที่มา - Google

mk Sat, 06/09/2025 - 20:03

Continue reading...